Файл robots.txt – это текстовый файл, который располагается на сервере в корневой директории веб-сайта. Он является одним из инструментов, которые используются для управления поведением поисковых роботов на сайте. Файл robots.txt является необязательным элементом, и его наличие или отсутствие не влияет на индексацию сайта поисковыми системами, однако он часто используется веб-мастерами для указания инструкций роботам.

Файл robots.txt позволяет определить, какие страницы сайта должны быть сканированы и индексированы поисковыми системами, а какие наоборот – скрыть от индексации. В нем можно указать различные правила для разных поисковых роботов – например, запретить доступ к части сайта для определенного робота или указать приоритеты относительно частоты и глубины сканирования. Таким образом, файл robots.txt позволяет владельцам сайтов более точно управлять тем, как именно поисковые системы работают с их сайтом.

Правильное использование файла robots.txt может помочь улучшить индексацию сайта поисковыми системами и защитить его от нежелательного сканирования, что особенно важно для сайтов с большим объемом контента. Однако неправильная настройка этого файла может привести к проблемам с индексацией сайта или даже полному его исключению из поисковой выдачи. Поэтому перед созданием и настройкой файла robots.txt рекомендуется ознакомиться с документацией поисковых систем и учесть все нюансы, связанные с его использованием.

Значение файла robots.txt для поисковых систем

Файл robots.txt представляет собой текстовый файл, расположенный в корневом каталоге сайта. Он содержит специфические правила, известные как «правила доступа», которые указывают какие разделы сайта должны проходить индексацию поисковыми роботами.

Директивы в файле robots.txt

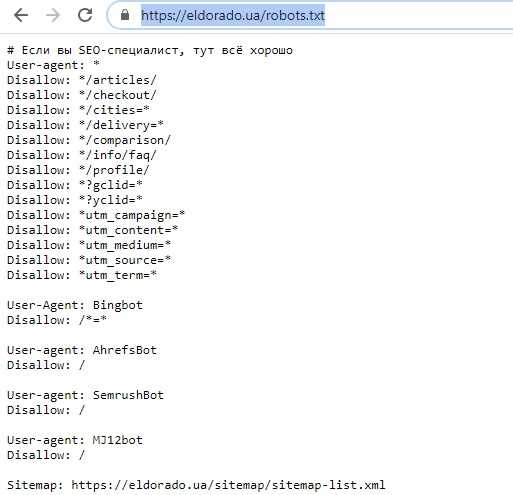

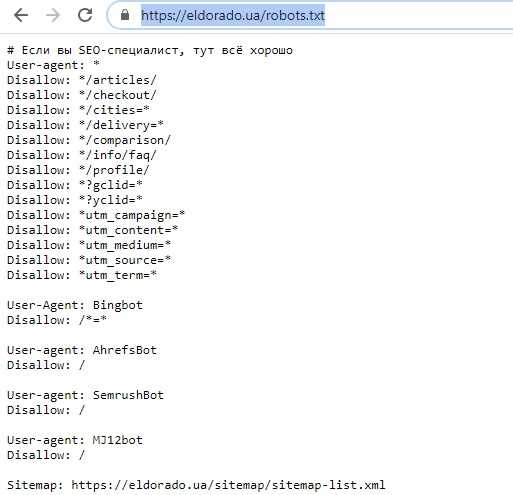

Файл robots.txt содержит различные директивы, с помощью которых можно контролировать поведение поисковых роботов при индексации сайта. Некоторые из наиболее распространенных директив включают:

- User-agent: Эта директива указывает конкретному роботу инструкции, которые будут следовать за этим правилом.

- Disallow: Эта директива указывает роботу, какие разделы сайта запрещены для индексации. Следуя этому правилу, роботы должны игнорировать указанные директиве URL-адресы.

- Allow: Эта директива указывает роботу, какие разделы сайта разрешены для индексации. Обычно используется в сочетании с директивой Disallow.

- Sitemap: Эта директива указывает на местоположение карты сайта, которая помогает поисковым роботам понять структуру и содержимое сайта.

Значение для поисковых систем

Файл robots.txt играет важную роль в SEO (оптимизации поисковых систем) и контроле доступа поисковых роботов к содержимому сайта. С помощью файла robots.txt веб-мастера могут указывать поисковым роботам, какие страницы следует индексировать, а какие не следует. Это позволяет управлять тем, какая информация будет показана в поисковых результатах, и обеспечивает более эффективную индексацию сайта.

Без файла robots.txt поисковый робот имеет доступ ко всем разделам сайта и может индексировать абсолютно всю информацию. Однако, с помощью файла robots.txt веб-мастера могут ограничивать доступ к конфиденциальной или нежелательной информации, например, страницам с личными данными или административным доступом.

Как создать и настроить файл robots.txt

После создания файла, вы можете использовать различные правила и директивы, чтобы указать, какие страницы вашего сайта следует индексировать и сканировать, а какие — нет. Каждая директива начинается с ключевого слова, за которым следует двоеточие, а затем указывается значение директивы. Ниже представлены некоторые примеры наиболее распространенных директив:

- User-agent: Название поискового робота или «*» для всех поисковых роботов.

- Disallow: Запрет на индексацию страницы или директории.

- Allow: Разрешение на индексацию конкретной страницы или директории после использования Disallow.

- Sitemap: Указание находящегося на вашем сайте файла карты сайта.

После настройки файла robots.txt, сохраните его и загрузите на сервер в корневую директорию вашего веб-сайта. Затем проверьте эффективность вашего файла, используя различные инструменты для проверки robots.txt, доступные онлайн.

Периодически обновляйте файл robots.txt, чтобы отражать изменения на вашем веб-сайте и учитывать новые страницы и директории. Также не забывайте регулярно проверять ваш файл robots.txt, чтобы убедиться, что он правильно настроен и соответствует вашим потребностям.